早起晨读,看到一篇很有用的文章。

作者是Abid Ali Awan,文章是3月15日就是今天发表在 KDnuggets。

KD代表知识发现(Knowledge Discovery)的意思。

KDnuggets 由Gregory Piatetsky-Shapiro创立。

KDnuggets是数据科学、机器学习、人工智能和分析方面的领先网站。

由Matthew Mayo(kdnuggets dot com 的编辑 1)编辑。

文章的题目是《在笔记本电脑上使用 LLM 的 5 种方法》(5 Ways To Use LLMs On Your Laptop)。

读完之后,很受启发。

什么人需要在本地PC上运行大语言模型呢?

其实场景还是蛮多的。

比如,跟国家机关工作人员、国家安全机关、武警部队、公安机关、军事院校等等涉密的部门相关人员,

他们一方便要紧跟时代步伐,享受最新最前沿科技的福利,另一方面,要按照涉密保密相关的规定和要求,使用的专用电脑不能联网。

再比如,在绝大多数中小学校,可能并不允许学生使用上网的电脑,考虑到分心、超链接迷航等因素,如果孩子们在老师的带领下,既不用上网,又能使用大语言模型,哪该多好啊?!

那么,问题来了,他们如何在在本地 PC 上运行大型语言模型,以获得具有更多控制、隐私和个性化的自定义 AI 功能。

Abid Ali Awan的这篇文章中多介绍的5种方法就超级赞了,可以算是及时雨了!

在这篇文章中,Abid Ali Awan讨论在本地使用大型语言模型的五种方法。大多数软件与几乎所有的主流操作系统兼容,并且可以轻松下载和安装以立即使用。

通过在笔记本电脑上使用大语言模型,用户可以自由选择自己的大模型。

任何人,只需从 HuggingFace 中心下载模型并开始使用即可。

此外,用户还可以授予这些应用程序对项目文件夹的访问权限,并生成情景敏感响应。

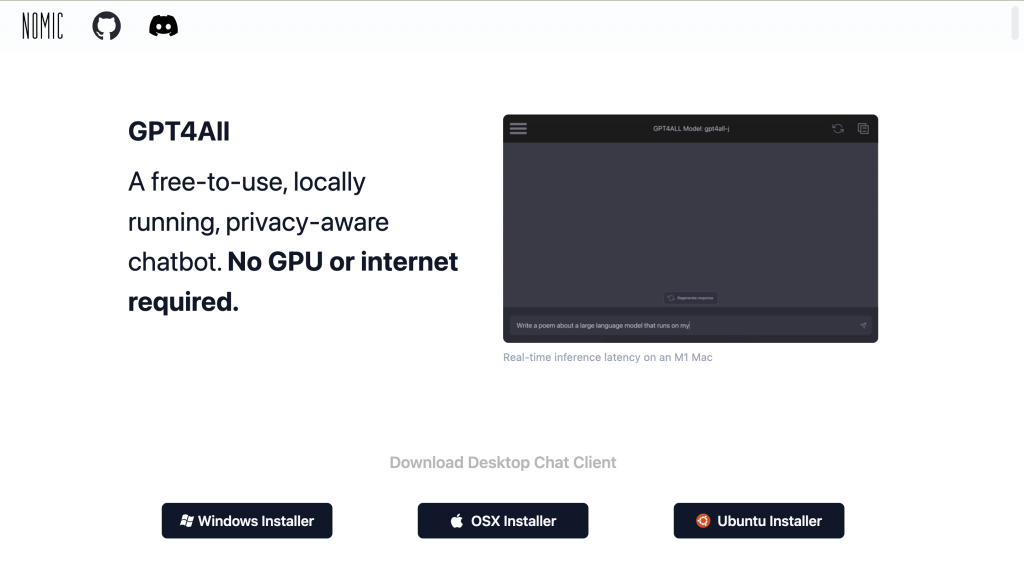

1. GPT4ALL

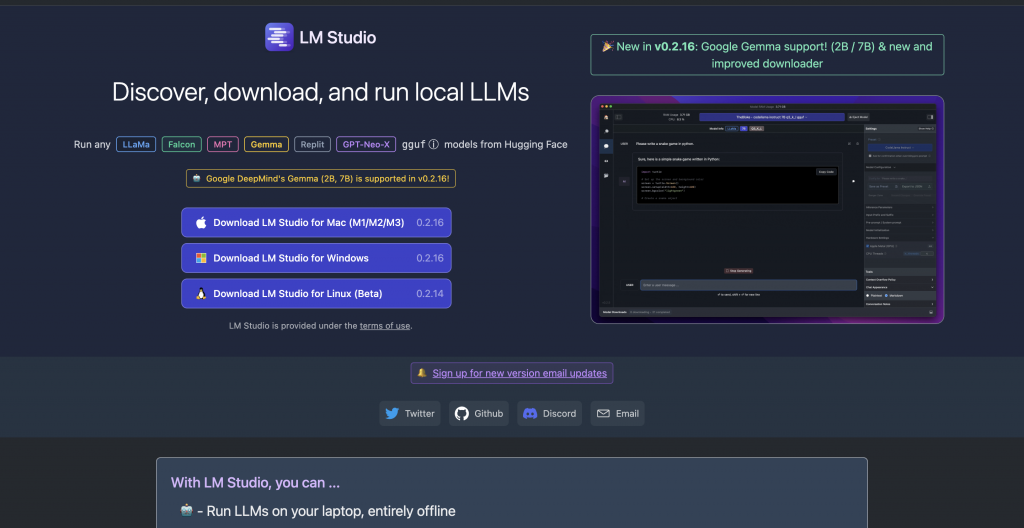

2. LM Studio

3. Ollama

https://github.com/ollama/ollama

4. LLaMA.cpp

https://github.com/ggerganov/llama.cpp

5. NVIDIA Chat with RTX

如果您想利用最新的大语言模型,同时又保持数据安全和私密,您就可以使用Abid Ali Awan的这篇文章中介绍的 GPT4All、LM Studio、Ollama、LLaMA.cpp 或 NVIDIA Chat with RTX 等这五个软件工具。

他所介绍的每个工具都有其独特的优势,无论是易于使用的界面、命令行可访问性还是对多模式模型的支持。

用户只要通过正确的设置,便可以在本地电脑上部署一个强大的人工智能助手,可以生成定制的上下文感知响应。

在文章的最后,Abid Ali Awan建议从 GPT4All 和 LM Studio 开始,因为它们满足了大部分基本需求。

之后,如有进一步需求,用户可以尝试 Ollama 和 LLaMA.cpp,

最后尝试使用 RTX 聊天。