人工智能一日千里。

随着越来越多的类似ChatGPT之类的大语言模型的涌现,一个新的问题涌现出来了,那就是:

将ChatGPT之类的大语言模型应用于自己的任务和工作之中,是否安全?

或者简单地说,如何判断将ChatGPTy用于工作是否安全?

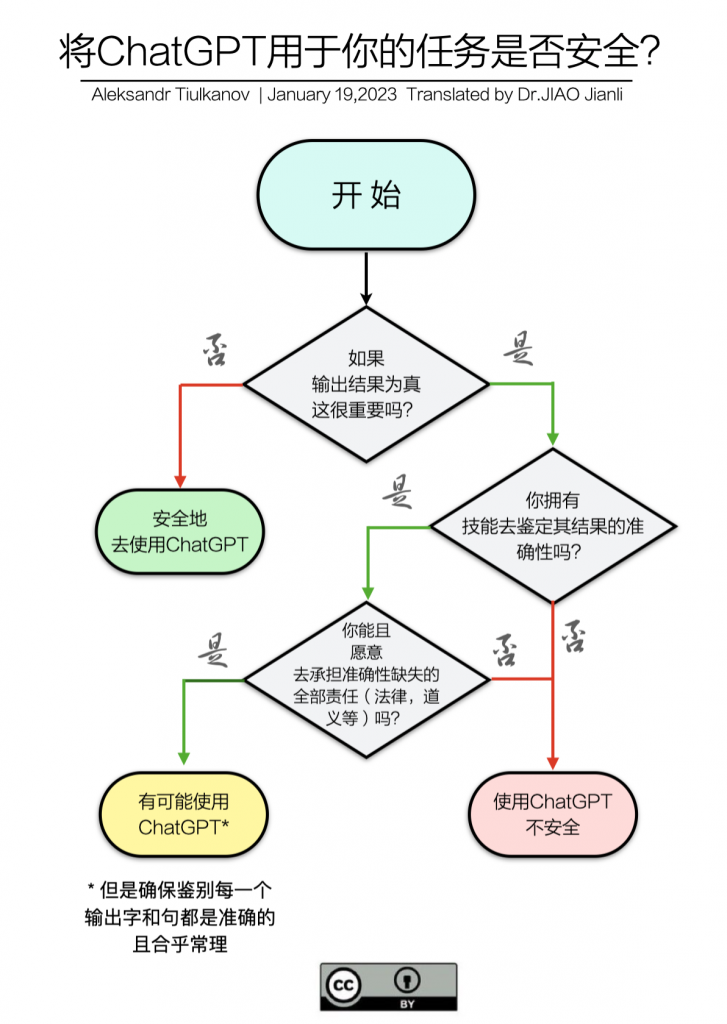

1月19日, Aleksandr Tiulkanov 的一个流程图,简单明了地告诉了我们每一个大语言模型用户这个问题的答案:

第一个需要做出判断的是:如果输出的结果为真,这很重要吗?

如果不重要,那没关系,您随便用,反正真假都不是重要!

如果很重要,那就需要进入第二个判断:你拥有技能去鉴定其结果的准确性吗?

如果没有这个技能,就是说,我们无法判定输出的结果是否正确准确,那么,在这样的情况下,使用ChatGPT来完成一些任务和工作,就是不安全的!

如果用户拥有这个技能,那就需要进入第三个判断:你能够并且愿意去承担准确性缺失的全部法律的和道义上的责任么?

如果不能承担,或者不愿意承担,那么就是不安全的!

如果可以承担,并且愿意承担责任,那么,在这样的情况下,使用ChatGPT去完成一些任务和工作,可能是安全的!

但是要确保鉴别每一个输出的字和句子都是准确的并且合乎常理的!

有了Aleksandr Tiulkanov的这个流程图,我们在使用包括ChatGPT、百度文心一言、讯飞星火认知大模型等大语言模型的时候,就拥有了一个可以遵循地判定流程,来判定自己将大语言模型用于任务和工作的安全性了。

读者诸君,您还有哪些方法决策是否可以安全地使用大语言模型?

欢迎您跟帖分享您的主张!

Photo by Johnnie Walker